CONSIDERACIONES PREVIAS SOBRE DEEPLEARNING

La teoría de redes neuronales y sus algoritmos fue propuesta en los años 40. A nivel de Ingeniería, durante este tiempo se ha estado trabajando en el Data Mining o Mineria de Datos.

Sin embargo, en esta época, la capacidad computacional, no permitía afrontar estos cálculos con eficacia. Gracias a la eclosión del Big Data, con gran cantidad de datos estructurados y no estructurados, unido a la mejora de los sistemas HPC, ha permitido llegar a sistemas Machine learning & Deep learning eficaces. La idea fundamental, es que en los últimos años, los datos han crecido de forma exponencial, en especial, en sector como la imagen médica, la bioinformática, etc.

En estos entornos, Deep learning, permite afrontar la necesidad de buscar patrones entre cientos o miles de datos no estructurados sean de imágenes, patrones de comportamiento, etc.

Compañías como NVDIA o Intel (con su adquisición de Altera), están interesadas en estas tecnologías, porque aunque es posible acercarse al entrenamiento de la máquina desde procesadores de propósito general como son los Broadwell, a nivel de productividad, es más eficiente, descargar de esta tarea al procesador principal y realizarla desde un coprocesador. Dado que para esta tarea, es suficiente con simple precisión (o incluso media), el resultado es que tarjetas GPU como las que posee NVDIA de más de 3.000 cores, son un elemento ideal para acercarse a esta problemática. Además, la tecnología Pascal (frente a la antigua Kepler o incluso Maxwell), a supuesto en algunos casos, el aumento del 100% de rendimiento en Tflops y también el doble de ancho de banda a memoria, lo que ha mejorado mucho la eficiencia para este tipo de cálculos.

Estos sistemas también llamados anteriormente neuronales, se comportan mejor con mayor número de cores menos potentes (como los que ofrecen GPUs y coprocesadores, ya sean FPGA o Phi) y con más dificultad, en procesadores Xeon Broadwell, por ejemplo, que son excelentes en procesos de propósito general y como ejecución de sistemas operativos.

También empieza a haber un ecosistema de software de gran interés, con herramientas propietarias como Mathlab o de código libre como R Python. Google y otras compañías también han desarrollado sus propios algoritmos.

Es quizá la parte teórica, la que más puede interesar a los investigadores. Sin embargo, tiene una gran aplicación práctica, que bebe de esta investigación base, en campos entre los que cabe mencionar:

Detección asistida por ordenador

Será la aplicación más común en el futuro más próximo por su relativa facilidad de implementación. Estos sistemas pueden ayudar a alertar a los radiólogos sobre las lesiones sospechosas que requieren una revisión más profunda. Esto implica que el análisis será más rápido y reduce el riesgo del error humano.

Imagen cuantitativa

Herramientas de imagen cuantitativa ayudan a los especialistas a segmentar, visualizar y cuantificar lo que están viendo. Esto puede agilizar los procesos y simplifica el proceso de toma de decisiones.

Herramientas de apoyo a la toma de decisiones

Combinan las dos áreas anteriores para ayudar a crear herramientas automatizadas de flujo de trabajo para los profesionales. Pueden suministrar pautas y objetivos específicos de análisis detallado después de un análisis previo efectuado de forma automática por estos sistemas.

Diagnóstico asistido por ordenador

Las herramientas de diagnóstico asistido por ordenador combinan todas las herramientas antes mencionadas para ofrecer diagnósticos respaldados por probabilidades. Los sistemas no harán el diagnóstico final, pero si a un radiólogo, el resultado de la ejecución de un algoritmo de Deep Learning, le informa que un cierto diagnóstico tiene alrededor de un noventa por ciento de probabilidad de ser correcto, el radiólogo puede centrarse en confirmar ese diagnóstico en lugar de perder tiempo en revisar otros casos en los que la probabilidad de existir un diagnóstico es muy baja.

Como base de todo ello, se utiliza una red neuronal artificial autodidacta que ha aprendido a partir de miles de casos hasta el momento y continuará mejorando con cada nuevo caso que analiza.

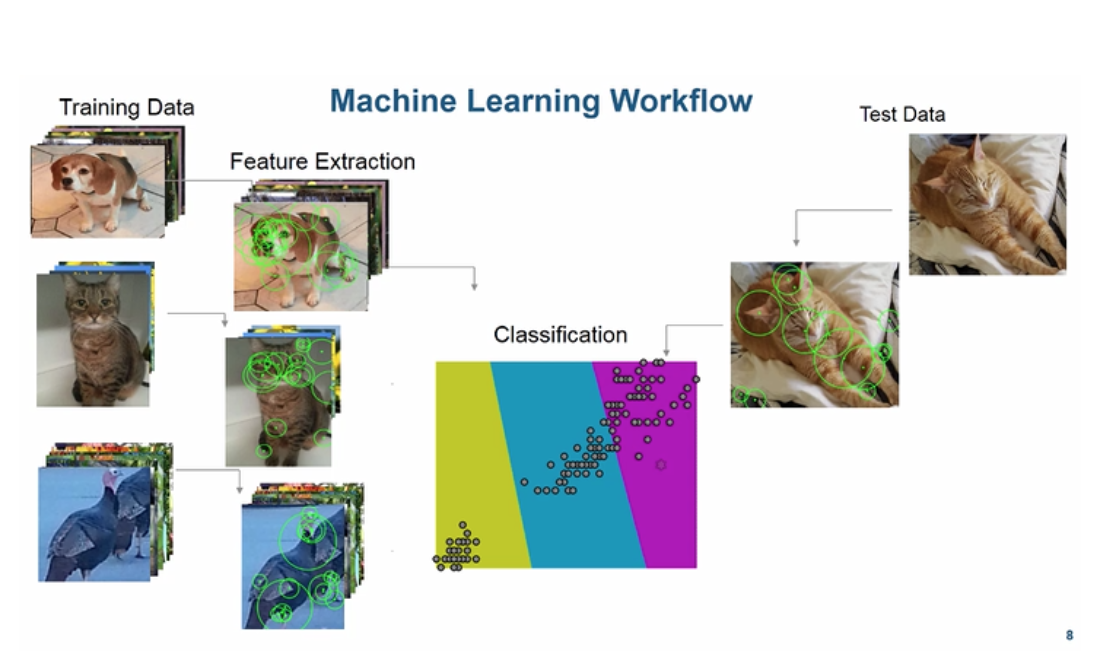

Volviendo a hablar de la herramienta de Mathlab, el reconocimiento de patrones en imágenes o incluso videos, empieza a estar en órdenes del 80-90% de acierto, una vez que tenemos un sistema bien entrenado, con patrones previos.

Dentro de Mathlab el aprendizaje de máquinas para visión por computador, está muy logrado, pudiendo tener patrones de aprendizaje que son bastante certeros cuando deben identificarse imágenes similares.

SIE, como Platinum Partner y HPC Specialist de Intel y Partner de NVDIA, ha tenido acceso las últimas tecnologías en este campo, tanto a la tecnología Pascal de NVIDIA con Cuda 8, como en las nuevas implementaciones de Intel Phi Knight Landing, de las cuales tiene gran experiencia en el campo de HPC.