Pasamos de un ancho de banda de 32 GB/s a 64 GB/s.

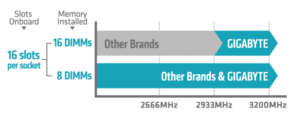

Pero no solo esto ha crecido, también lo ha hecho el acceso a memoria: de 4 canales a 2666 Mhz, pasando por 6 canales a 2933 Mhz, hasta llegar a los 8 canales a 3200 Mhz. Es decir, puesto por procesador y en GT/s (Gigatransaciones por segundo), hemos pasado del limite de 10,4 GT/s a 25,6 GT/s.

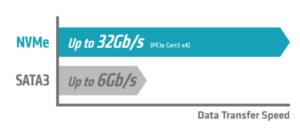

Como es lógico, esto necesitaba ir aparejado, de la velocidad a disco y esto, también ha aumentado en los discos SSD, que ya no tienen la limitación de la mecánica y pueden ir a velocidad de chip de memoria persistente (sin perdida de datos), pasando de la limitación del bus SATA, que solo podía entregar 6 Gb/s y por tanto, obtener discos de máximo 100.000 IOPS, a los 32 Gb/s, que permiten discos en Gen 3 de hasta un millón de IOPS (Input Output por segundo) y de hasta 2 millones de IOPS en Gen 4.

Además, lógicamente estas velocidades, pueden ser potenciadas a través de las tecnologías de RAID, que permiten agrupar varios discos y así obtener más rendimiento y/o seguridad añadida en RAID 0, 1, 10, 5 y 6. En este sentido, ha habido varias aproximaciones:

1º Por parte de Intel, con el VROC, que permitía que el procesador gestionara RAID de discos en un entorno hardware/software, desde la propia bios de Gigabyte y con licencia adicional. En principio solo 2 discos SSD NVME y con expander hasta 24 discos, con la consiguiente carga para el procesador y sacrificio de lanes de control. Esto lo vimos ya en la 2ª generación escalable o conocida como CascadeLake y ha sido mejorado en la 3ª generación o IceLake.

2º Por parte de Broadcom, propietario de la tecnología clásica de las controladoras LSI Raid, que llevan un procesador especializado RISC, que descarga el procesador. Estas controladoras hasta ahora solo eran capaces de manejar discos SATA3 y SAS3. Las nuevas controladoras que se lanzan ahora, permiten manejar también discos NVME, hasta un máximo de 4 unidades de forma directa, pudiendo hacer RAID 0, 1 y 5. Logicamente el nuevo procesador RISC es más potente y podrá seguir manejando discos SAS/SATA y/o discos NVME, con ciertas limitaciones.

3º NVIDIA ha lanzado ya esta tecnología y las plataformas verán la luz para el primer Q1 (Feb-Abr 2022, es compañía lleva los trimestres desfasados respecto a los naturales), un nuevo concepto. La reciente GPU T1000, ha sido rediseñada y rebautizada como SupremeRAID™ SR-1000 para poder usarte como controladora RAID, bajo un nuevo concepto que han acuñado y que se ha denominado GRAID SupremeRAID™. Esta innovadora solución, libera el 100% del rendimiento de los discos NVMe SSD, sin sacrificar la seguridad de los datos.

Mientras las tecnologías de RAID tradicionales, generaban cuellos de botella en los discos SSD, la nueva solución GRAID desarrolla un nuevo sistema hardware/software, que supera esta limitación, en los discos NVME SSD U.2 (de 2,5”) y PCI-E 4.0.

GRAID SupremeRAID trabaja instalando un controlador virtual NVMe en el sistema operativo (disponible en Windows Server y las principales distribuciones de LINUX) e integra un dispositivo PCIe 4.0 con un alto rendimiento, que el procesador puede manejar como un solo dispositivo, no necesitando sacrificar sus prestaciones, tan importantes en sistemas HPC.

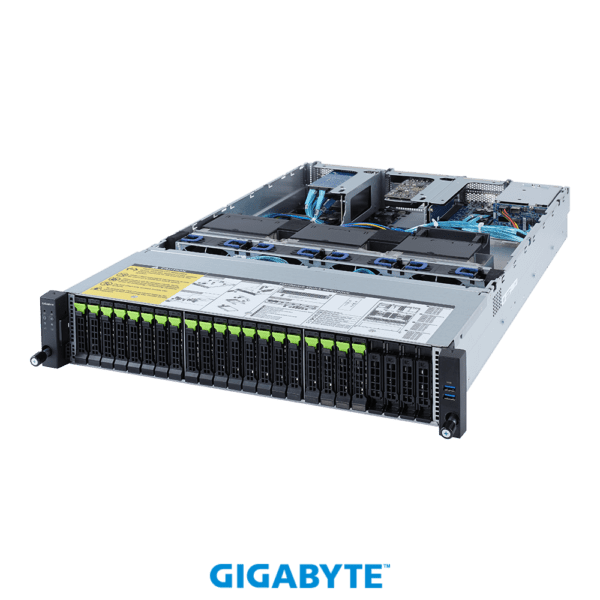

Esta tecnología ya está presente en el SIE Ladón All-flash 4.0, que permite ofrecer hasta 285 TB netos, con un performance de hasta 6 millones de IOPS y 100GB/s de throughput de red. Está basado en la plataforma R282-Z9G, que puede alojar hasta 20 discos NVME U.2 PCI-E 4.0 y hasta 128 cores con dos procesadores AMD Milan y una salida a red, basada en la tarjeta Mellanox MCX653105A-EFAT, que puede entregar por bus PCI-E 4.0 100 Gb/s, bien en tecnología Infiniband HDR 100 Gb/s o Ethernet a la misma velocidad.

Llegados a este punto, con equipos con hasta 8 tarjetas A100 de 80 GB de memoria por bus NVLINK a 600 Gb/s o los nuevos equipos de hasta 10 tarjetas A40 de 48 GB, ambos enfocados a Deep Learning (training) e Inteligencia Artificial, a muchos de ustedes, les surgirá la cuestión de que los sistemas SIE Ladon en muchos casos, no son máquinas aisladas y están integradas dentro de un clúster.

Efectivamente, este ancho de banda a nivel interno de las máquinas, nos obliga a plantearnos como interconectarlas.

En primer lugar, la apuesta de Sistemas Informáticos Europeos, es por la tecnología Infiniband de Mellanox HDR a 100 y 200 Gb/s, pero también compatibles Ethernet, para poder integrar estas soluciones dentro de las redes clásicas.

Infiniband supone unos paquetes de comunicación, con unas cabeceras y colas, mucho más pequeñas que el protocolo Ethernet, lo que permite paralelizar procesos entre máquinas. Así mismo, ofrece una latencia, que está en el orden de magnitud, de la que tienen 2 procesadores que se encuentran en la misma placa.

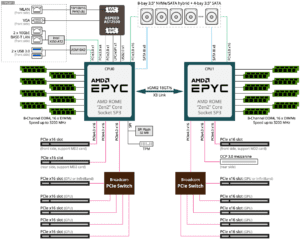

Sin embargo, para poder realizar procesos sin cuellos de botella, por ejemplo en el caso de GPUs, ha sido necesario, que el bus NVLINK interno de los equipos, se haya extendido entre máquinas a través del protocolo NVSWITCH. Esto es posible a través del concentrador Broadcom PCIe Switch, como puede verse en el siguiente esquema.

Aquí puede verse, como uno de los slots PCIe 4.0 x16, puede ser sacrificado, para en vez de poner una GPU, poner una tarjeta Mellanox HDR a 200 Gb/s y conectar a través de la red Infiniband, GPUs de distintas máquinas, con mucha menos carga para el procesador AMD principal del equipo.

Toda esta tecnología, se ve con más claridad, en el siguiente video de NVIDIA, donde está muy bien explicada esta nueva tecnología NVSWITCH

No obstante, seguimos en el mismo escollo y es como interconectar toda esta nueva velocidad con nuestras redes clásicas de Ethernet.

Bueno, en primer lugar, disponemos de switch de 32 bocas con tecnología Linux Cumulus. Sobre esta tecnología, tienen una página muy interesante de Eduardo Collado donde se explica muy bien, este nuevo estándar abierto.

Como iba diciendo, podemos tener troncales de Mellanox en Ethernet de hasta 100 y 200 Gb/s, para aquellos equipos que necesitan acceder a alta velocidad a soluciones All-Flash 4.0 de alto rendimiento.

Además, SIE ofrece tarjetas Mellanox HDR 100 Gb/s de doble puerto, donde por uno de los puertos pueden negociar protocolo Infiniband y por el otro protocolo Ethernet, con el consiguiente ahorro de slot y de inversión, en una sola tarjeta de conectividad PCI-E 4.0 x16, que puede disponer de dos slots de este tipo, para conectar simultáneamente con los dos procesadores de la máquina y evitar cuellos de botella.

Para distribuir una conectividad menos costosa al resto de la red, disponemos del modelo DXS 3610 54T-SI del fabricante D-LINK, que dispone de 6 puertos 100 Gb/s Ethernet y que nuestra empresa interconectar sin problema a través de QSFP+ con las tarjetas Mellanox HDR 100, anteriormente mencionadas.